Qu’est-ce que Screaming Frog ?

Screaming Frog, ou plus exactement Screaming Frog SEO Spider, est un robot d’exploration de sites web personnel créé par l’entreprise web anglaise Screaming Frog, lancée en 2010. Tout comme les crawlers des moteurs de recherche, il parcourt un site internet, en extrait des informations et vérifie les différents problèmes rencontrés. On l’installe sur son ordinateur personnel, ce qui permet d’y avoir tout le temps accès. Il est accessible à tous, aux webmasters amateurs souhaitant améliorer le référencement naturel de leur site comme aux agences SEO professionnelles. Toutefois, il faudra être en mesure de comprendre les données extraites d’un site afin d’en corriger les erreurs et d’en améliorer le référencement.

À quoi sert Screaming Frog ?

Screaming Frog sert avant tout à vérifier et à analyser son site internet pour en améliorer le référencement naturel. Il fait un véritable audit d’un site internet : il analyse les tailles des différents éléments, recherche le contenu dupliqué, vérifie le maillage interne et la profondeur de clics des différentes pages, corrige les URLs canoniques, liste les images, donne un aperçu des méta-descriptions et autres balises présentes, et bien d’autres choses encore.

Il est bien sûr possible d’utiliser des outils comme Google Analytics, ou SEMRush, mais Screaming Frog agit comme un crawler personnel complet et précis. Il permet en fait de voir ce que voient les robots d’indexation des moteurs de recherche.

Comment configurer Screaming Frog ?

Le logiciel est disponible dans une version gratuite limitée comprenant l’analyse de 500 URLs et les fonctions principales. Une version payante est proposée à 185 € par an pour un nombre illimité d’URLs et des fonctions annexes.

Une fois téléchargé, il faut prendre le temps de configurer correctement l’outil. Comme vous le verrez en téléchargeant Screaming Frog, la configuration du robot d’indexation est assez complexe, même si tout est parfaitement expliqué sur le site de l’entreprise.

Configuration du Spider

Ici, on détermine la configuration de base de l’outil :

- le premier onglet, « Crawl », permet de choisir ce que le robot va analyser et enregistrer ;

- dans l’onglet « Extraction », on détermine les informations que l’outil va pouvoir extraire du site ;

- le troisième onglet, « Limits », permet de définir certaines limites, utile par exemple si votre site est particulièrement lourd ;

- l’onglet « Rendering » détermine le mode de rendu de l’analyse ;

- l’onglet « Advanced » propose des configurations avancées, comme la possibilité de limiter le temps d’attente de chargement d’une page ;

- dans le dernier onglet « Preferences », on peut y choisir des limites, en termes de pixels ou de caractères, au-delà desquelles Screaming Frog remontera une erreur.

Configuration du fichier robots.txt

Ici, il s’agit de choisir comment le crawler interagira avec le fichier robots.txt du site analysé. Vous pourrez choisir de le respecter, de l’ignorer ou bien de l’ignorer tout en remontant les erreurs trouvées.

Réécriture des URLs

Comme son nom l’indique, « URL Rewriting » permet de réécrire les URLs à la volée, par exemple en supprimant un élément.

Include et Exclude

Dans cette partie, on choisit quelles URLs doivent être prise en compte lors du crawl et lesquelles peuvent être omises, idéal pour les sites contenant de nombreuses pages.

Speed

La configuration de la vitesse est à prendre en compte pour les sites de grande taille. On peut augmenter le « Max Threads » pour augmenter la vitesse de l’analyse. Mais attention, car une vitesse importante signifie un nombre de requêtes HTTP élevé, ce qui ralentira sûrement votre site et peut potentiellement faire cracher le serveur.

User agent configuration

Ici, on choisit quel user agent sera utilisé pour analyser le site internet. C’est « Screaming Frog » par défaut, mais il est possible de choisir « Google Bot » par exemple.

Custom Search and Extraction

Cette partie de la configuration de Screaming Frog permet tout simplement de faire ressortir spécifiquement certaines URLs, en utilisant un mot-clé ou un élément HTML. C’est un outil très puissant dans la gestion des mots-clés.

API Access

API Access permet de faire remonter des données issues d’autres outils, comme Google Search Console ou Majestic SEO.

Authentification

On peut enregistrer les identifiants de connexion et les mots de passe pour permettre au crawler d’avoir accès à l’ensemble d’un site.

System

Il est possible de gérer la mémoire utilisée. Si vous possédez un site contenant des centaines de milliers d’URLs, vous pourrez allouer en plus de la RAM un peu de mémoire du disque dur.

Crawl mode

Vous pourrez choisir entre 3 modes de crawl : « spider », « list mode » et « SERP mode ».

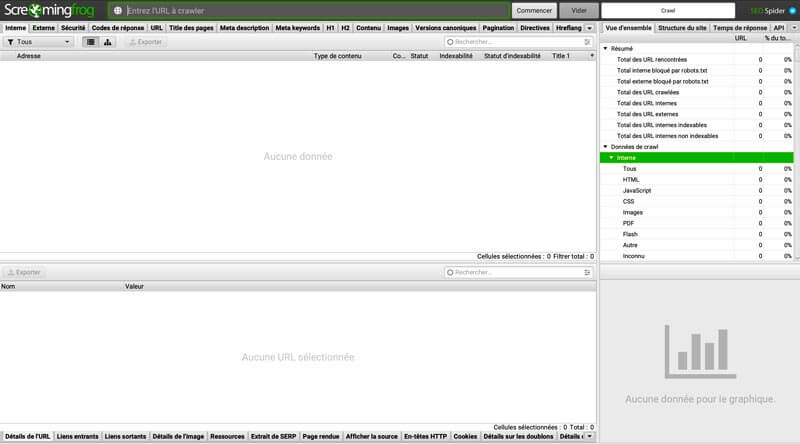

Comment analyser les données de Screaming Frog ?

À la fin d’une analyse, le logiciel présentera 3 parties :

- la liste des ressources analysées ;

- Le détail d’une ressource sélectionnée ;

- L’analyse effectuée.

C’est cette troisième partie qui contient les données remontées, comme celles concernant le code HTML, les temps de chargement, la pagination du site et les images. À vous ensuite d’améliorer le référencement naturel de votre site internet.

Pour cela, il est recommandé de faire appel à une agence SEO professionnelle qui pourra mettre en place avec vous une stratégie de référencement naturel, de manière à faire apparaître les différentes pages de votre site dans les premiers résultats des recherches effectuées sur Google.