Comment vérifier si votre site est indexé par Google ?

Avant de chercher à corriger un problème, encore faut-il être sûr qu’il existe. Pour cela, il existe plusieurs moyens simples et efficaces de savoir si votre site ou vos pages sont indexés.

Utiliser la commande “site:” dans Google

C’est la méthode la plus rapide pour avoir une première idée.

Tapez dans la barre de recherche Google : site:votresite.com

Par exemple : site:premiere.page

Si Google vous retourne des résultats, c’est qu’il connaît au moins certaines pages de votre site. Mais attention, cette méthode a ses limites :

- Elle ne garantit pas que toutes vos pages soient indexées

- Elle ne fournit pas d’informations techniques sur les raisons d’une éventuelle non-indexation

Cela reste un bon point de départ pour un premier état des lieux.

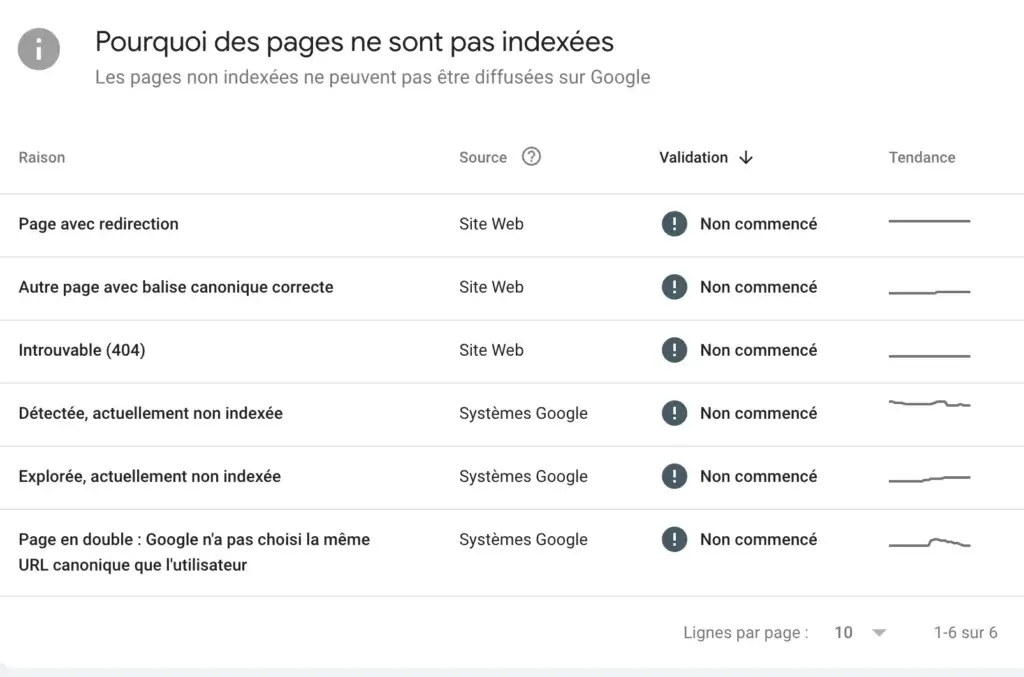

Analyser le rapport de couverture dans Google Search Console

Si vous utilisez Google Search Console (et vous devriez), le rapport de couverture de l’index vous donnera une vision bien plus précise de la situation.

Rendez-vous dans l’onglet “Index > Pages” pour consulter les différentes raisons pour lesquelles certaines pages ne sont pas indexées par Google. Voici comment interpréter les principaux statuts :

- Page avec redirection : la page renvoie automatiquement vers une autre, elle n’est donc pas indexée.

- Autre page avec balise canonique correcte : Google a choisi d’indexer une autre version de la page, considérée comme canonique.

- Introuvable (404) : la page renvoie une erreur « non trouvée », donc elle ne peut pas être indexée.

- Détectée, actuellement non indexée : la page a été repérée par Google mais n’a pas encore été explorée.

- Explorée, actuellement non indexée : la page a bien été analysée, mais Google a choisi de ne pas l’ajouter à son index (souvent à cause de sa faible valeur perçue).

- Page en double : Google n’a pas choisi la même URL canonique que l’utilisateur : Google a ignoré l’URL déclarée comme canonique et préfère une autre version.

Ce rapport est l’un des plus précieux pour comprendre où en est votre site vis-à-vis de l’indexation Google.

L’outil d’inspection d’URL : votre meilleur allié

Toujours dans Search Console, l’outil d’inspection d’URL permet de vérifier le statut d’une page précise. C’est particulièrement utile si certaines pages clés ne ressortent pas dans Google malgré leur publication.

Il vous permet de savoir :

- Si l’URL a été crawled et indexée

- Si elle est explorable

- Quelle est la dernière date de passage de Googlebot

- Si des erreurs empêchent l’indexation

Cet outil vous permet également de demander une indexation manuelle pour accélérer le processus sur une page que vous venez de publier ou de corriger.

Bon à savoir :

- Si votre site est tout juste lancé, il est normal que l’indexation prenne quelques jours.

- Google n’indexe pas automatiquement toutes les pages. Elles doivent d’abord être découvertes, explorées, puis jugées pertinentes pour mériter une place dans l’index.

Maintenant que vous savez comment diagnostiquer l’état d’indexation de votre site, voyons les causes les plus fréquentes qui peuvent expliquer pourquoi vos pages ne sont toujours pas visibles dans Google.

Les causes principales d’un site non indexé par Google

Vous avez vérifié : certaines pages – voire l’ensemble de votre site – ne sont pas indexées. Avant de chercher des solutions trop techniques, commencez par passer en revue les raisons les plus fréquentes. Elles sont souvent plus simples qu’on ne l’imagine.

Le site est bloqué par un fichier robots.txt

Le fichier robots.txt donne des instructions aux robots d’exploration (comme Googlebot). Une ligne mal placée peut empêcher Google de visiter tout ou partie de votre site.

Par exemple :

User-agent: * Disallow: /

👉 Cette directive empêche tous les robots d’accéder à l’ensemble du site.

Nos conseils :

- Vérifiez ce fichier à l’adresse votresite.com/robots.txt

- Assurez-vous qu’il n’interdit pas l’accès aux répertoires importants

- Supprimez les blocages une fois le site prêt à être exploré

Des balises “noindex” empêchent l’indexation

La balise <meta name="robots" content="noindex"> demande explicitement à Google de ne pas indexer une page.

C’est utile pendant une refonte… mais catastrophique si elle reste en ligne par erreur.

Bon réflexe :

- Inspectez vos pages avec l’outil d’inspection de la Search Console

- Retirez toute balise “noindex” sur les pages que vous souhaitez indexer

Le site est trop récent ou encore en construction

Google n’indexe pas instantanément les nouveaux sites. Il faut :

- Que le domaine soit découvert (via un lien ou un sitemap)

- Que les pages soient explorables

- Qu’elles présentent un intérêt suffisant

Si votre site est tout juste lancé, il est normal qu’aucune page ne soit encore indexée.

Ce que vous pouvez faire :

- Envoyer votre sitemap dans Search Console

- Demander l’indexation manuelle des pages clés

- Créer des liens externes pour signaler votre présence

Le contenu est de faible qualité ou dupliqué

Google évite d’indexer les pages :

- Trop courtes

- Pauvres en valeur ajoutée

- Dupliquées ou très similaires à d’autres déjà indexées

Cela concerne souvent :

- Les pages catégories vides

- Les fiches produits identiques sur des sites e-commerce

- Le contenu généré automatiquement sans relecture

Nos conseils :

- Rédigez du contenu original, utile et structuré

- Supprimez ou combinez les pages très similaires

- Évitez les copier-coller, même internes

Le site présente des erreurs techniques bloquantes

Certaines pages peuvent être accessibles pour l’utilisateur, mais inaccessibles pour les bots :

- Pages renvoyant des erreurs 404 ou 500

- Chargement via JavaScript sans fallback HTML

- Problèmes de redirection ou d’URL canonique mal définie

À vérifier :

- L’état d’exploration dans Search Console

- Les codes de réponse HTTP des pages (avec un outil comme Screaming Frog)

- La présence de contenu exploitable sans exécution JavaScript

Tableau comparatif : les problèmes d’indexation courants

| Problème d’indexation | Symptômes visibles | Solutions concrètes |

|---|---|---|

| Blocage dans le fichier robots.txt | Aucune page indexée / message d’erreur dans la Search Console | Modifier ou supprimer les directives Disallow: bloquantes |

| Balise “noindex” présente | Pages exclues de l’index malgré un contenu pertinent | Retirer la balise <meta name="robots" content="noindex"> des pages concernées |

| Site trop récent ou encore en construction | Aucune page visible dans Google, sitemap inconnu | Soumettre un sitemap, demander l’indexation, créer des liens externes |

| Contenu de faible qualité ou dupliqué | Pages visibles dans Search Console mais non indexées / Exclusion pour « contenu pauvre » | Améliorer la qualité, l’originalité, ou fusionner les pages similaires |

| Erreurs techniques (404, 500, JavaScript, etc.) | Pages non explorées, erreurs dans Search Console ou outils de crawl | Corriger les erreurs HTTP, améliorer l’accessibilité HTML, vérifier les redirections |

Les problèmes techniques qui bloquent l’indexation

Même si votre site semble fonctionner correctement pour les visiteurs, des erreurs invisibles peuvent empêcher Googlebot de l’explorer ou de l’indexer correctement. Voici les obstacles techniques les plus courants :

Robots.txt, balises meta et directives mal configurées

Certains paramètres mal réglés peuvent interdire involontairement l’accès à vos pages :

- Fichier robots.txt trop restrictif

- Balises

<meta name="robots" content="noindex">mal placées - Attributs HTTP X-Robots-Tag envoyés depuis le serveur

Conseil : Inspectez régulièrement ces éléments dans vos pages modèles (templates) et vérifiez l’impact de chaque directive sur les pages stratégiques.

Sitemap manquant ou incorrect

Un sitemap XML aide Google à découvrir vos pages plus rapidement. Mais s’il est :

- Mal structuré

- Incomplet

- Non soumis à la Search Console

…il devient inutile, voire contre-productif.

Nos conseils :

- Vérifiez que toutes les URLs du sitemap sont valides (200, indexables, sans redirection)

- Soumettez le sitemap dans la Search Console

- Mettez-le à jour dès qu’un changement important est fait sur votre site

Mauvais maillage interne ou URLs non accessibles

Si une page importante n’est reliée par aucun lien interne, Googlebot peut ne jamais la découvrir. De même, si une URL dépend de paramètres complexes ou de filtres dynamiques, elle peut être ignorée.

À surveiller :

- Pages orphelines (aucun lien entrant)

- Menus ou filtres générés dynamiquement en JavaScript

- Liaisons depuis des contenus bloqués (ex : pages en noindex)

Pages non explorables (JavaScript, erreurs serveur, redirections)

Certaines technologies ou erreurs rendent l’exploration difficile :

- Contenu chargé uniquement via JavaScript (sans fallback HTML)

- Pages qui renvoient des erreurs 500, 403 ou des redirections en boucle

- Redirections vers des URLs non indexables ou en erreur

Ce que vous pouvez faire :

- Vérifiez les codes de réponse HTTP avec un crawler SEO

- Testez vos pages avec l’outil d’inspection d’URL

- Préférez un rendu côté serveur ou SSR pour les pages critiques

💡 Trop technique ? Première Page peut réaliser un audit complet de votre site pour identifier les blocages, vous proposer les meilleures recommandations et vous aider à faire indexer vos pages et gagner en visibilité sur Google.

Contenu, UX et SEO : des leviers trop souvent négligés

L’indexation ne repose pas uniquement sur des paramètres techniques. Même si votre site est parfaitement accessible à Googlebot, un contenu pauvre ou une expérience utilisateur médiocre peuvent suffire à freiner – voire bloquer – son indexation.

Voyons comment ces éléments influencent votre visibilité sur Google.

Un contenu pauvre, dupliqué ou trop similaire

Google ne cherche pas à indexer tout le web. Il privilégie les pages qui apportent une valeur ajoutée réelle. Si votre site contient :

- des textes très courts,

- des blocs copiés-collés depuis d’autres sites (ou d’autres pages internes),

- ou des fiches produits similaires à des dizaines d’autres,

… alors il y a de fortes chances que certaines pages soient exclues de l’index volontairement.

Ce qu’il faut éviter :

- Les pages « placeholder » (ex. : catégorie sans produits, landing vide)

- Les duplications massives (e-commerce, CMS mal configuré)

- Le contenu généré automatiquement sans relecture humaine

Nos conseils :

- Rédigez un contenu original, utile, et structuré autour de vos mots-clés stratégiques

- Combinez ou redirigez les pages trop proches

- Ajoutez des éléments différenciants (avis clients, FAQ, données structurées)

Une expérience utilisateur dégradée freine l’exploration

Même si cela peut sembler indirect, l’UX influence l’indexation. Un site lent, instable ou difficile à parcourir peut décourager Googlebot et nuire à l’analyse de vos contenus.

Les signaux pris en compte incluent :

- La vitesse de chargement (Core Web Vitals)

- La structure des pages (titres, maillage, navigation)

- La mobilité (affichage sur mobile, responsive design)

À optimiser :

- Réduisez les temps de chargement (compression, lazy loading, mise en cache)

- Structurez le contenu avec des balises claires (h1, h2, p, etc.)

- Améliorez le maillage interne pour guider le robot vers les pages stratégiques

Des signaux de faible qualité pénalisent l’indexabilité

Google ne se base pas uniquement sur le contenu en lui-même. Il évalue aussi des signaux contextuels qui permettent d’estimer la pertinence globale d’un site.

Par exemple :

- Une page sans liens entrants (internes ou externes) sera jugée moins importante

- Un site sans sitemap ni structure logique sera mal compris

- Une trop grande part de pages exclues ou “soft 404” peut dégrader la perception globale

Bon à savoir :

Même une bonne page peut ne jamais être indexée si Google juge qu’elle s’inscrit dans un site globalement pauvre ou mal optimisé.

Conclusion – Pourquoi mon site n’est pas indexé par Google ?

Un site non indexé, c’est un site qui n’existe pas aux yeux de Google. Qu’il s’agisse d’un blocage technique, d’un mauvais paramétrage, ou d’un contenu jugé insuffisant, les causes sont multiples – mais rarement insurmontables.

Dans cet article, vous avez appris à :

- Vérifier l’indexation de vos pages grâce à la commande “site:” et à la Search Console

- Lire et comprendre les statuts d’exclusion dans les rapports Google

- Identifier les principaux freins à l’indexation : robots.txt, noindex, erreurs 404, duplications…

- Corriger les erreurs et améliorer la structure et le contenu pour mieux guider Googlebot

Pourquoi votre site n’est pas indexé par Google ? La réponse est parfois technique, parfois éditoriale – mais dans tous les cas, il existe des solutions claires pour y remédier.